Un decodificador de lenguaje no invasivo, que funciona como una interfaz cerebro-ordenador capaz de reconstruir frases completas a partir de imágenes de resonancia magnética funcional (fMRI), puede “leer” la mente de las personas tras largas sesiones de entrenamiento: elabora textos complejos y no solo palabras u oraciones sueltas. Se basa en parte en un modelo de Inteligencia Artificial (IA) similar a los que impulsan ChatGPT de Open AI y Bard de Google.

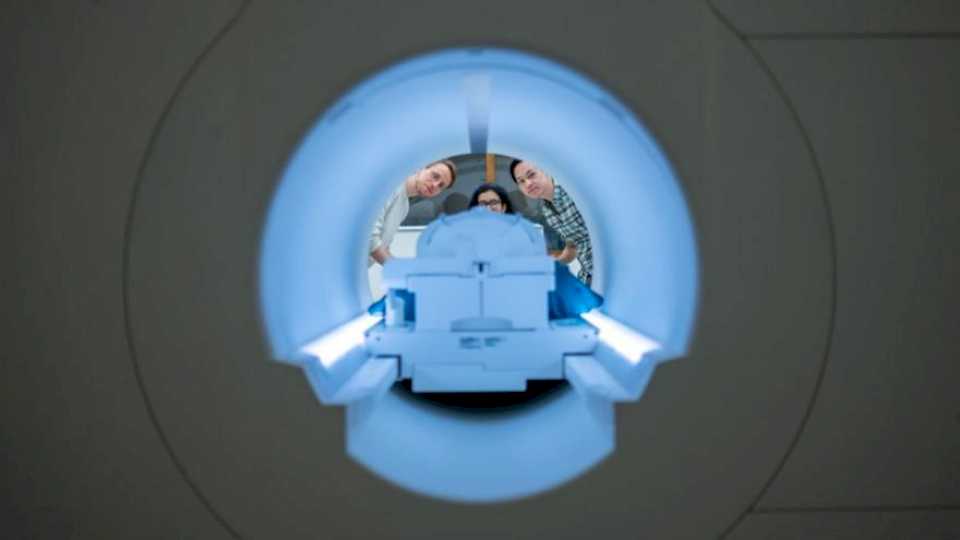

Investigadores de la Universidad de Texas en Austin, en Estados Unidos, han creado un sistema de Inteligencia Artificial (IA), denominado técnicamente decodificador semántico, que logra leer los pensamientos de las personas y transformarlos en textos extensos a modo de narración. Para obtener los resultados deseados, la interfaz cerebro-ordenador necesita varias horas de entrenamiento con un escáner de imágenes de resonancia magnética funcional (fMRI): luego de aprender a “traducir” las imágenes cerebrales, puede decodificar de forma independiente aquello que lee en la mente de las personas.

Una nueva voz

Según una nota de prensa, la innovación podría ayudar a las personas mentalmente conscientes pero que no pueden hablar, por ejemplo como consecuencia de derrames cerebrales, a comunicarse nuevamente de manera eficiente. Aunque ya existen otros proyectos de decodificadores similares, algunos de ellos son invasivos y requieren implantes quirúrgicos. En tanto, otros solo identifican palabras o frases cortas.

Por el contrario, el nuevo sistema es no invasivo y puede producir narraciones extensas a partir de los pensamientos de las personas. De acuerdo a lo indicado en el nuevo estudio, publicado recientemente en la revista Nature Neuroscience, la interfaz llega a revelar el contenido de un video que la persona está observando, solamente a partir de las imágenes cerebrales y sin apoyarse en ningún registro audiovisual externo.

“Para un método no invasivo, este es un verdadero avance en comparación con lo que se ha hecho anteriormente, que generalmente era producir palabras sueltas u oraciones cortas. Estamos logrando que el modelo decodifique un lenguaje continuo durante largos períodos de tiempo y con ideas complicadas”, destacó en el comunicado citado con anterioridad el científicos Alex Huth, uno de los responsables de la investigación.

El problema de la privacidad

Sin embargo, no es difícil pensar que este tipo de tecnologías puedan utilizarse con fines muy diferentes a los originales, empleándose para limitar la privacidad de las personas.

“Que una máquina pueda acabar leyendo tu mente, una vez entrenada, significa que es posible que, de manera involuntaria y sin tu consentimiento (por ejemplo, mientras duermes) pueda ir traduciendo retazos de tu pensamiento. Nuestra mente ha sido hasta ahora la guardiana de nuestra intimidad. Podemos guardarnos celosamente ciertos pensamientos, los más inconfesables, si así lo queremos. Sin embargo, este hallazgo podría ser el primer paso para que en el futuro esa libertad se viera comprometida”, declaró el científico español David Rodríguez-Arias Vailhen, de la Universidad de Granada, quien no participó de la investigación, en una publicación de SMC España.

Ante esto, el equipo de científicos aclaró que el mecanismo solo es efectivo cuando existe la cooperación de la persona: de lo contrario, el sistema produce frases desconectadas y sin sentido. Esto se debe a la necesidad de un extenso período de entrenamiento, en el cual la interfaz debe aprender a traducir los pensamientos que genera cada individuo.

Basado en un esquema de Inteligencia Artificial similar a los populares sistemas ChatGPT de Open AI y Bard de Google, el nuevo modelo aún no es práctico para su uso fuera del laboratorio, debido a su dependencia del entrenamiento con un escáner fMRI.

Sin embargo, los investigadores creen que este trabajo podría transferirse a otros sistemas de imágenes cerebrales más portátiles, como la espectroscopia funcional del infrarrojo cercano (fNIRS), haciendo posible una mayor funcionalidad fuera de los laboratorios y acercándolo a la vida práctica.

Referencia

Semantic reconstruction of continuous language from non-invasive brain recordings. Jerry Tang, Amanda LeBel, Shailee Jain and Alexander G. Huth. Nature Neuroscience (2023). DOI:https://doi.org/10.1038/s41593-023-01304-9