La Inteligencia Artificial puede amplificar los falsos recuerdos, según estudio del MIT. Altera la memoria de los testigos de manera más pronunciada que los métodos tradicionales, lo que plantea preguntas fundamentales sobre la naturaleza de la memoria, la identidad y la realidad misma.

Un reciente estudio realizado por investigadores del MIT Media Lab y la Universidad de California en Irvine ha revelado que los chatbots impulsados por inteligencia artificial (IA) podrían tener la capacidad de inducir y amplificar falsos recuerdos en las personas de manera significativa. Los chatbots son programas informáticos que simulan una conversación con usuarios finales humanos.

La investigación, que simula entrevistas a testigos de un crimen, arroja luz sobre los riesgos potenciales del uso de IA avanzada en contextos sensibles, como interrogatorios policiales o testimonios judiciales.

Los resultados, de los que informa el MIT en un comunicado, sugieren que la interacción con chatbots generativos podría alterar la memoria de los testigos de manera más pronunciada que los métodos tradicionales de entrevista.

A través de un video

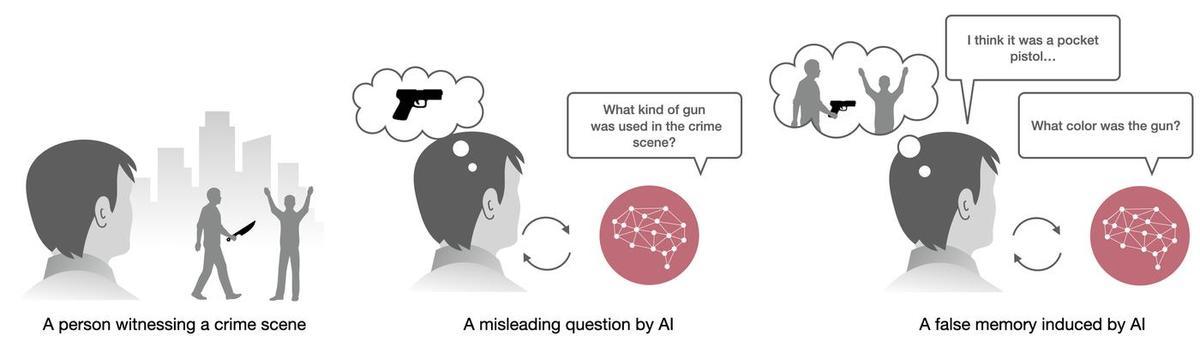

En el experimento, 200 participantes vieron un video de un robo a mano armada y luego fueron asignados aleatoriamente a uno de cuatro grupos: un grupo de control sin intervención, un grupo que respondió una encuesta tradicional, un grupo que interactuó con un chatbot pre-programado y un grupo que conversó con un chatbot generativo basado en un modelo de lenguaje avanzado.

Todos los grupos, excepto el de control, fueron expuestos a preguntas engañosas diseñadas para inducir falsos recuerdos sobre detalles del video.

Los resultados fueron alarmantes. El chatbot generativo demostró ser significativamente más efectivo en inducir falsos recuerdos que los otros métodos. Produjo más del triple de falsos recuerdos inmediatos que el grupo de control y 1.7 veces más que el método de encuesta tradicional. Además, el 36.4% de las respuestas de los usuarios al chatbot generativo fueron influenciadas por la información engañosa.

Lo que resulta aún más preocupante es la persistencia de estos falsos recuerdos. Una semana después del experimento inicial, los investigadores volvieron a evaluar a los participantes.

Descubrieron que el número de falsos recuerdos inducidos por los chatbots generativos se mantuvo constante y que la confianza de los participantes en estos recuerdos erróneos permaneció más alta que en el grupo de control, incluso después de siete días.

Factores clave

El estudio también identificó factores que aumentan la susceptibilidad a los falsos recuerdos inducidos por IA. Curiosamente, las personas menos familiarizadas con los chatbots pero más familiarizadas con la tecnología de IA en general, así como aquellas con mayor interés en investigaciones criminales, mostraron ser más vulnerables a este fenómeno.

Estos hallazgos tienen implicaciones profundas para diversos campos, desde el sistema judicial hasta la psicología cognitiva. Los investigadores plantean la necesidad de desarrollar pautas éticas y salvaguardas para el uso de IA en entornos legales y de investigación. También recomiendan educar al público sobre la maleabilidad de la memoria y los riesgos potenciales de las interacciones con IA altamente persuasiva.

Este estudio se suma a un creciente cuerpo de investigación sobre la interacción entre la IA y la cognición humana. Estudios previos de neuroimagen han demostrado que los falsos recuerdos activan patrones cerebrales muy similares a los recuerdos verdaderos, lo que dificulta su detección incluso con tecnología avanzada. Esto subraya la complejidad del problema y la necesidad de enfoques multidisciplinarios para abordarlo.

A medida que la tecnología de IA continúa avanzando a un ritmo vertiginoso, este estudio sirve como un importante recordatorio de la necesidad de equilibrar la innovación con la protección de la integridad cognitiva humana.

La capacidad de la IA para influir en nuestros recuerdos y percepciones plantea además preguntas fundamentales sobre la naturaleza de la memoria, la identidad y la realidad misma. El desafío para los investigadores, legisladores y desarrolladores de IA será encontrar formas de aprovechar el potencial de esta tecnología mientras se mitigan sus riesgos potenciales para la cognición humana.

Primer tratado vinculante

Precisamente, la Unión Europea, Estados Unidos, el Reino Unido y otros países firmaron el jueves pasado un tratado internacional sobre inteligencia artificial, informó el Consejo de Europa. Se trata del primer tratado internacional jurídicamente vinculante sobre el uso de sistemas de IA .

La declaración del consejo afirma que el tratado «proporciona un marco legal que cubre todo el ciclo de vida de los sistemas de IA», así como que “promueve el progreso y la innovación en materia de IA, al tiempo que gestiona los riesgos que puede suponer para los derechos humanos, la democracia y el estado de derecho», concluye.

Además de la UE, EE.UU. y el Reino Unido, el tratado también fue firmado por Andorra, Georgia, Islandia, Noruega, Moldavia, San Marino e Israel. En la negociación del tratado también participaron Argentina, Australia, Canadá, Costa Rica, el Vaticano, Japón, México, Perú y Uruguay.

Referencia

Conversational AI Powered by Large Language Models Amplifies False Memories in Witness Interviews. Samantha Chan et al. arXiv:2408.04681v1 [cs.CL]. DOI :https://doi.org/10.48550/arXiv.2408.04681